nocheinPoet schrieb:Ist doch recht klar, es geht nicht darum es gleichzusetzen, es geht um einen Vergleich um dann konkret einen eindeutigen Unterschied herauszuarbeiten.

nocheinPoet schrieb:Ist doch recht klar, es geht nicht darum es gleichzusetzen, es geht um einen Vergleich um dann konkret einen eindeutigen Unterschied herauszuarbeiten.

Negev schrieb:Deine komplette Argumentation baut darauf auf, LLMs mit einem menschlichen Gehirn zu vergleichen.

Negev schrieb:Deine komplette Argumentation baut darauf auf, LLMs mit einem menschlichen Gehirn zu vergleichen.

Was heißt, baut darauf auf, bin ja nicht nur ich, der KI mit den Fähigkeiten von Menschen vergleicht, wird so eigentlich überall gemacht. Fing damals schon mit dem Schachspiel an, wie gut kann ein Computer das. Nun kommt die KI schon mit in einer der letzten unserer Domains, sie kann ganz normal sprechen. Das war bisher uns vorbehalten. Also, klar wird da verglichen, warum auch nicht?

Negev schrieb:Selbst wenn ein Vergleich legitim wäre: ...

Negev schrieb:Selbst wenn ein Vergleich legitim wäre: ...

Was soll das heißen, warum sollte der Vergleich nicht legitim sein?

Negev schrieb:Man kann zwar, bis zu einem gewissen Grad, Äpfel und Birnen miteinander vergleichen! Aber dies führt nicht dazu, dass Äpfel und Birnen gleich sind.

Negev schrieb:Man kann zwar, bis zu einem gewissen Grad, Äpfel und Birnen miteinander vergleichen! Aber dies führt nicht dazu, dass Äpfel und Birnen gleich sind.

Es geht nicht um Äpfel und Birnen und Ziel ist es nicht, das der Vergleich dazu führt, dass beides nun gleich ist. Du zitierst doch oben meine Aussage, da steht doch ganz klar und deutlich, um was es geht, es geht darum den Unterschied herauszuarbeiten. Nichts mit gleich machen.

Negev schrieb:Wer weiß denn schon, welche Komponente letztlich zu einem Innenleben führt?

Negev schrieb:Wer weiß denn schon, welche Komponente letztlich zu einem Innenleben führt?

Vermutlich keiner, und ich habe nicht nach jemanden gefragt. Was soll Deine Frage?

Negev schrieb:Zu behaupten, eine rein statistische Architektur könne dasselbe leisten, ist eine unbelegte Annahme.

Negev schrieb:Zu behaupten, eine rein statistische Architektur könne dasselbe leisten, ist eine unbelegte Annahme.

Ich habe nicht behauptet, eine rein statistische Architektur könnte das leisten, zitiere mich dann dazu bitte entsprechend. Wenn ich schreibe, wir können etwas nicht ausschließen, oder es wäre wohl möglich, behauptet ich damit nicht, dass es so ist. Altes Spiel, wenn ich schreibe, ich bin der Meinung, KI könnte ein Bewusstsein haben oder entwickeln, dann ist es nicht meine Behauptung, dass KI eines hat.

Negev schrieb:Damit verlässt du den Boden der empirischen Fakten. Deine Position ist keine wissenschaftliche Analyse mehr, er ist eine hochspekulative philosophische Annahme. Solange dafür keine Belege vorliegen, ist sie eine Glaubensfrage.

Negev schrieb:Damit verlässt du den Boden der empirischen Fakten. Deine Position ist keine wissenschaftliche Analyse mehr, er ist eine hochspekulative philosophische Annahme. Solange dafür keine Belege vorliegen, ist sie eine Glaubensfrage.

Ich bin der, hier, der die ganz Zeit immer wieder erklärt hat, die Frage nach dem Bewusstsein ist nur mit Meinung zu beantworten, es gibt dazu keine Tatsachenaussage. Wir können es nicht messen. Es ist eben nur Meinung, und nun willst Du mir genau das erklären? Warum? Mir ist das die ganze Zeit klar, darum ging es die ganze Zeit.

Es gibt für Bewusstsein keine empirische Evidenz, nicht mal beim Menschen, darum schrieb ich ja

Atue schrieb am 16.08.2025:Die KIs, die wir derzeit in der Lage sind zu bauen, haben kein Bewusstsein - bestenfalls simulieren sie, eines zu haben. Das ist ein entscheidender Unterschied.

Atue schrieb am 16.08.2025:Die KIs, die wir derzeit in der Lage sind zu bauen, haben kein Bewusstsein - bestenfalls simulieren sie, eines zu haben. Das ist ein entscheidender Unterschied.

nocheinPoet schrieb am 16.08.2025:Lese mal ein wenig hier nach, eventuell gibt der wer einen Link, das mit Bewusstsein ist raus, man kann nichts belegen, werde das Menschen eines haben, noch das sie es nicht haben, noch das KI eines hat oder nicht hat. Der Begriff "Bewusstsein" ist raus, damit kann man nicht arbeiten.

nocheinPoet schrieb am 16.08.2025:Lese mal ein wenig hier nach, eventuell gibt der wer einen Link, das mit Bewusstsein ist raus, man kann nichts belegen, werde das Menschen eines haben, noch das sie es nicht haben, noch das KI eines hat oder nicht hat. Der Begriff "Bewusstsein" ist raus, damit kann man nicht arbeiten.

So, und dann hat wer damit hier weiter gemacht?

Und ganz grundsätzlich, geht es nicht in jeder Diskussion nur um empirische Evidenz, natürlich schaut man sich auch Entwicklungen an, und natürlich hinterfragt man diese. Wie mein Zitat ja zeigt, ist das mit dem Bewusstsein für viele immer und immer wieder ein Thema in Bezug zur KI. Weil das was wir bauen immer und immer ähnlicher wird, natürlich fragen dann da Menschen sich auch, kann das auch richtig fühlen? Weiß es, dass es existiert? Kann es Angst haben?

Meine Aussage die ganze Zeit war dazu hier immer, wissen wir nicht, können wir nicht wissen, diese Fragen können wir nicht mit "empirischen Fakten" beantworten.

Denn hier wurde immer wieder stur behauptet, es sei eine Tatsache, dass KI kein Bewusstsein hat, kein Innenleben. Und genau das können wir eben nicht wissen, keine empirischen Fakten, und wenn Du es eine Glaubensfrage nennen willst, von mir aus, dann glaubst Du oder

@Tanne oder wer auch immer, dass KI kein Bewusstsein hat und haben kann. Hab ich doch kein Problem mit.

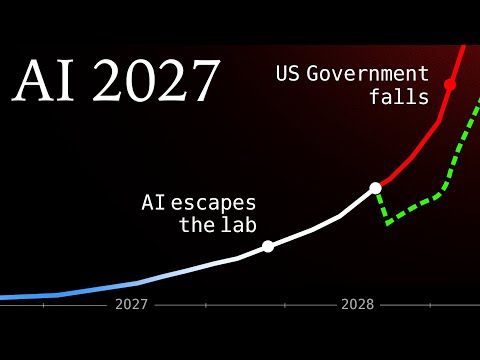

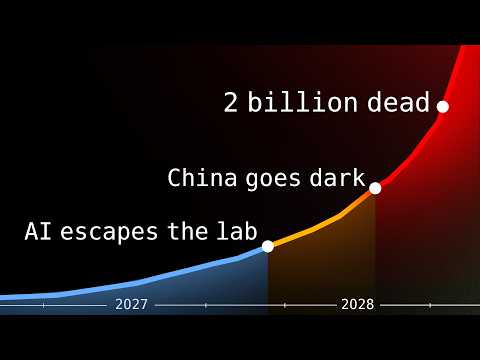

CharlyPewPew schrieb am 21.08.2025:Ich habe selbst ein wenig mit KI-Programmierung zu tun und könnte jedes mal ko****, wenn ich diese völlig überzogenen Anschauungen irgendwo lese... "KI wird uns alle versklaven", "KI wird die Menschheit vernichten/ersetzen..." etc. pp. Das einzig intelligente an unseren momentanen LLMs sind die Entwickler der Transformer- und Embedding Algorithmen (und natürlich weiteren).

CharlyPewPew schrieb am 21.08.2025:Ich habe selbst ein wenig mit KI-Programmierung zu tun und könnte jedes mal ko****, wenn ich diese völlig überzogenen Anschauungen irgendwo lese... "KI wird uns alle versklaven", "KI wird die Menschheit vernichten/ersetzen..." etc. pp. Das einzig intelligente an unseren momentanen LLMs sind die Entwickler der Transformer- und Embedding Algorithmen (und natürlich weiteren).

Die tatsächliche Gefahr von KI ist der Missbrauch durch Fakenews-Erstellung etc. Aber das wurde hier ja auch schon ausreichend diskutiert.

nocheinPoet schrieb:Kann man sehen wir man will, und um die Menschheit zu vernichten, muss eine KI nicht superintelligent sein, je intelligenter, um so geringer vermutlich die Gefahr. Sie kann Fehler machen, und wir wissen, sie kann lügen und betrügen und hat in Test versucht einen Menschen sterben zu lassen.

nocheinPoet schrieb:Kann man sehen wir man will, und um die Menschheit zu vernichten, muss eine KI nicht superintelligent sein, je intelligenter, um so geringer vermutlich die Gefahr. Sie kann Fehler machen, und wir wissen, sie kann lügen und betrügen und hat in Test versucht einen Menschen sterben zu lassen.

Und man könnte auch mal schauen, was unter "Intelligenz" nun genau zu verstehen ist, wenn eine KI Aufnahmetests an Universitäten besteht, und vieles mehr, also für mich fällt das schon unter Intelligenz.

Ich drehe Deine "Argumentation" einfach mal um, eventuell könnte man auch kotzen, wenn Menschen glauben, sie seien mit ihrem Hirn etwas ganz außergewöhnliches und ganz viel mehr, als nur ein "Automat" der Informationen verarbeitet, aber was soll da sein?

Wir haben von der Physik den Determinismus, da ist wenig Raum für was wie "freier Wille" oder? Obendrauf hast Du als Kirsche dann von der QT noch echten Zufall, aber auch das macht uns nun nicht zu etwas Besonderen. Und was willst Du da nun noch mehr haben?

Was ist dieses besondere "Etwas", dass Dich so weit von allen LLMs und zukünftigen LLMs abhebt?

Ich sehe in aktuellen Modellen mehr was wie ein "Mensch", mit Einschränkungen, aktuell keinen Körper, wenig Sinn, kein Langzeitgedächtnis. Gibt auch Menschen, die solche Einschränkungen haben, aber man spricht ihnen da dann nicht die Intelligenz ab und erklärt, ja nun, ist nur noch Statistik, da steckt nichts mehr hinter.

Und die Frage war ja hier, was können wir als Tatsachen belegen?

So, ich habe mal das was Du nur zitierst hast hervorgehoben und den ganzen Beitrag von mir zitiert, er war eine Antwort an

@CharlyPewPew und ging nicht an Dich.

Negev schrieb:Was zukünftige LLM leisten können werden und ob sie dann noch als LLM bezeichnet werden können, steht auf einem vollkommen anderen Blatt!

Negev schrieb:Was zukünftige LLM leisten können werden und ob sie dann noch als LLM bezeichnet werden können, steht auf einem vollkommen anderen Blatt!

Und wo ist da Dein Problem? Ich habe hier einfach

@CharlyPewPew geantwortet, wir kommen glaub ich beide recht gut im Dialog klar. Natürlich kann ich hier im Thread nach der Entwicklung von LLs fragen und was uns von ihnen unterscheiden wird.

Negev schrieb:Bleibt nur deine Behauptung, das Bewusstsein mit den aktuellen LLMs möglich wäre.

Negev schrieb:Bleibt nur deine Behauptung, das Bewusstsein mit den aktuellen LLMs möglich wäre.

Ich diskutiere hier mit anderen Usern im Rahmen der Regeln des Forums, wenn Du da einen Verstoß siehst, kannst Du es melden, ansonsten obliegt es mir, was ich wie mit wem diskutiere, musst Du mir nicht vorgeben.

Negev schrieb:Und hier ignorierst du vollständig die komplexität des Gehirns. Lernen ist ein fortlaufender Porzess. Zu keinem Zeitpunkt ist das Gehirn, in irgendeiner Form statisch.

Negev schrieb:Und hier ignorierst du vollständig die komplexität des Gehirns. Lernen ist ein fortlaufender Porzess. Zu keinem Zeitpunkt ist das Gehirn, in irgendeiner Form statisch.

Ich ignoriere gar nichts, ich diskutiere mit einem anderen User, Du musst da nicht ständig reinspringen. Ich habe auch nie die Komplexität des Gehirns ignoriert, mit meiner Aussage da, belege das doch einfach, wo genau hab ich das "ignoriert"?

Auch hab ich nie behauptet, das Hirn sei statisch. Oder? Sonst zitiere mich entsprechend aus meinem Beitrag, Du hast nur zwei Sätze zitiert, beides sind Fragen. Es ist ein Dialog mit

@CharlyPewPew, Du kannst ja gerne nachfragen, wenn Du was wissen willst, aber gebe mir nicht vor, wie ich hier mit anderen über was zu diskutieren habe.

Negev schrieb:Ich habe dir Bereits den Fall Henry Gustav Molaison vorgelegt, wie er neue motorische fähigkeiten erlernen konnte. In einem Nebensatz erklärst du:

Negev schrieb:Ich habe dir Bereits den Fall Henry Gustav Molaison vorgelegt, wie er neue motorische fähigkeiten erlernen konnte. In einem Nebensatz erklärst du:

nocheinPoet schrieb:Ich diskutiere das ja, und ich weiß schon um was es mir geht, es geht nicht um motorische Fähigkeiten. Und ich will dazu gar nichts behaupten, weil es mir darum ja gar nicht geht.

nocheinPoet schrieb:Ich diskutiere das ja, und ich weiß schon um was es mir geht, es geht nicht um motorische Fähigkeiten. Und ich will dazu gar nichts behaupten, weil es mir darum ja gar nicht geht.

Warum? Weil ein LLM nicht laufen kann? Für das lernen spielt es aber eine entscheidende Rolle.

Warum hatte ich erklärt, eventuell zitierst Du mal mehr Kontext von meinen Aussagen und reißt nicht nur fünf Worte aus Sätzen raus. Ich diskutiere das, was ich diskutieren will, im Rahmen der Regeln, denke das ist so schon angemessen.

Ich hatte es Dir auch genau erklärt, um was es mir geht, Langzeitgedächtnis und Kurzzeitgedächtnis, wie unterscheidet sich das funktional zwischen Hirn und aktuellen LLMs und was könnte man daraus ableiten. Das ist was ich diskutiere, nicht das Lernen von motorische Fähigkeiten beim Menschen. Macht auch keinen Sinn, aktuell haben die wenig davon, die LLMs.

Also meine Diskussion passt schon so wie sie ist.

nocheinPoet schrieb:Und auf der anderen Seite, gibt es Verletzungen beim Hirn, die ein solches zerstören, wo ein Mensch eben reagiert, wie eine KI, wenn man einen neuen Chat aufmacht. Alles plausibel.

nocheinPoet schrieb:Und auf der anderen Seite, gibt es Verletzungen beim Hirn, die ein solches zerstören, wo ein Mensch eben reagiert, wie eine KI, wenn man einen neuen Chat aufmacht. Alles plausibel.

Negev schrieb:Du wiederholst einfach nur deine Behauptung, ohne einen Beweis dafür zu bringen.

Negev schrieb:Du wiederholst einfach nur deine Behauptung, ohne einen Beweis dafür zu bringen.

Ich habe dazu Belege gemacht und es erklärt. Wenn Du meinst es reicht nicht, melde meinen Beitrag.

Hier hatte ich schon was dazu geschrieben:

Beitrag von nocheinPoet (Seite 110)Und hier:

nocheinPoet schrieb:Es geht um den Vergleich biologisches LLM und künstliches LLM, man schaut, wo gibt es aktuell noch signifikante Unterschiede und bedingen diese, dass es im biologischen LLM etwas gibt, etwas, dass es nicht in einem künstlichen geben könnte. Da war mal das "Argument" hier, Langzeitgedächtnis, aber das bedingt nicht die Manifestation von Qualia im Hirn. Man kann hier beide Wege zum Vergleichen gehen, zum Einen gibt es ja schon, wie ich erklärt habe, bei ChatGPT und auch bei Manus schon Erinnerungen, die über einzelne Chats hinausgehen, eine Art Langzeitgedächtnis.

nocheinPoet schrieb:Es geht um den Vergleich biologisches LLM und künstliches LLM, man schaut, wo gibt es aktuell noch signifikante Unterschiede und bedingen diese, dass es im biologischen LLM etwas gibt, etwas, dass es nicht in einem künstlichen geben könnte. Da war mal das "Argument" hier, Langzeitgedächtnis, aber das bedingt nicht die Manifestation von Qualia im Hirn. Man kann hier beide Wege zum Vergleichen gehen, zum Einen gibt es ja schon, wie ich erklärt habe, bei ChatGPT und auch bei Manus schon Erinnerungen, die über einzelne Chats hinausgehen, eine Art Langzeitgedächtnis.

Und auf der anderen Seite, gibt es Verletzungen beim Hirn, die ein solches zerstören, wo ein Mensch eben reagiert, wie eine KI, wenn man einen neuen Chat aufmacht. Alles plausibel.

Noch mal ganz deutlich, ich habe hier mit einem anderen User darüber diskutiert, wie es mit der Speicherung von Informationen ausschaut, Langzeit und Kurzzeit und LLMs und das Hirn verglichen, ganz normale Diskussion. Da gibt es keine Probleme, wenn Du eines hast, einen Regelverstoß meinst erkennen zu können, melde es, sonst lass mich meine Diskussion so führen, wie ich es möchte.

nocheinPoet schrieb:Ja und ein ChatGPT hat sein Kontextfenster, ist analog zu dem Kurzzeitgedächtnis. Und was soll das mit dem statisch, es geht darum, wie Informationen gespeichert werden, kurze Zeit und auf Dauer.

nocheinPoet schrieb:Ja und ein ChatGPT hat sein Kontextfenster, ist analog zu dem Kurzzeitgedächtnis. Und was soll das mit dem statisch, es geht darum, wie Informationen gespeichert werden, kurze Zeit und auf Dauer.

Negev schrieb:Nein. Ich habe vor einigen Monaten den Fauxpas begangen, ein Word-Dokument mit einem LLM zu vergleichen. Das geschah mit der Absicht, Dinge vereinfacht darzustellen. Aber, das Kontextfenster ist nicht mit einem Kurzzeitgedächtnis zu vergleichen. Das Kontexfenster ist zu 100% gleich zu einem Word-Dokument. Es ist ein Externer speicher. Ein Kurzzeitgedächtnis ist eine interne Komponente mit vielen Wechselwirkungen.

Negev schrieb:Nein. Ich habe vor einigen Monaten den Fauxpas begangen, ein Word-Dokument mit einem LLM zu vergleichen. Das geschah mit der Absicht, Dinge vereinfacht darzustellen. Aber, das Kontextfenster ist nicht mit einem Kurzzeitgedächtnis zu vergleichen. Das Kontexfenster ist zu 100% gleich zu einem Word-Dokument. Es ist ein Externer speicher. Ein Kurzzeitgedächtnis ist eine interne Komponente mit vielen Wechselwirkungen.

Doch, im Rahmen meines Vergleiches ist es genau so wie ich es beschreibe, darum ging es, ich sage nicht, es ist identisch, aber zu vergleichen. Und es ist mir ganz sicher hier im Forum im Rahmen der Regeln erlaubt so einen Vergleich zu machen, oder meinst Du, dass ist nicht gestatt?

nocheinPoet schrieb:Nein, wo genau siehst Du da ein falsches Dilemma? Warum in die falsche Richtung? Ich denke schon, dass ich weiß, wie ich über was hier mit anderen diskutieren möchte, die Antwort ging ja auch so nicht an Dich.

nocheinPoet schrieb:Nein, wo genau siehst Du da ein falsches Dilemma? Warum in die falsche Richtung? Ich denke schon, dass ich weiß, wie ich über was hier mit anderen diskutieren möchte, die Antwort ging ja auch so nicht an Dich.

Negev schrieb:Anstatt dein Argument zu verteidigen, weichst du auf die persönliche Ebene aus.

Negev schrieb:Anstatt dein Argument zu verteidigen, weichst du auf die persönliche Ebene aus.

Ich weiche nicht aus, ich frage Dich ganz deutlich, nun das dritte Mal, wo da ein falsches Dilemma sein soll, ganz konkret, ich muss mein Argument auch nicht verteidigen, aber so wie das klingt, greifst Du da was an?

Noch mal, wo ist da bei meiner Aussage ein falsches Dilemma? Zitiere meine Aussage entsprechen!

nocheinPoet schrieb:Nein, es ist eine ganz normale Behauptung, nicht außergewöhnlich, belege bitte, dass das außergewöhnlich ist.

nocheinPoet schrieb:Nein, es ist eine ganz normale Behauptung, nicht außergewöhnlich, belege bitte, dass das außergewöhnlich ist.

Negev schrieb:Nach allem was wir Wissen, ist deine Behauptung außergewöhnlich. Die Beweislast liegt bei dir.

Negev schrieb:Nach allem was wir Wissen, ist deine Behauptung außergewöhnlich. Die Beweislast liegt bei dir.

Nein, es ist eine normal Behauptung, wenn Du hier dazu behauptest, sie ist "außergewöhnlich", musst Du das belegen.

nocheinPoet schrieb:Habe auch noch ein Video einer Physikerin geliefert.

nocheinPoet schrieb:Habe auch noch ein Video einer Physikerin geliefert.

Negev schrieb:Eine Physikerin soll mir nun was genau erklären? Wie das menschliche Gehirn funktioniert? Das lass ich mir lieber von einem Neurowissenschaftler erklären. Oder will sie mir erklären, wie ein LLM aufgebaut ist? Das lass ich mir von einem Wissenschaftler aus dem Bereich Informatik mit Schwerpunkt erklären.

Negev schrieb:Eine Physikerin soll mir nun was genau erklären? Wie das menschliche Gehirn funktioniert? Das lass ich mir lieber von einem Neurowissenschaftler erklären. Oder will sie mir erklären, wie ein LLM aufgebaut ist? Das lass ich mir von einem Wissenschaftler aus dem Bereich Informatik mit Schwerpunkt erklären.

Es ging um meine Aussage, die Du "außergewöhnlich" findest und willst, dass ich das belege, ich habe das mit dem Video schon ein wenig belegt, wobei ich das nicht wirklich muss. Dass ist eben Stand in der Wissenschaft. So arbeitet das Universum, so sind die Naturgesetze, so entstehen Atome, so finden sie zu Molekülen zusammen, so gibt es Chemie, dann organische Chemie, Aminosäuren, draus dann Proteine, und Zellen. Das ist deterministisch, so wird das aktuell beschrieben, ohne Hokuspokus, und neben dem Determinismus haben wir eben noch aus der QT den Zufall.

Wenn Du nun behauptest, dass reicht nicht aus, da muss noch mehr sein, ist es eine eventuell "außergewöhnlich" Behauptung. Eventuell erklärst Du dann mal mehr dazu, ich hatte Dich ja schon danach gefragt:

nocheinPoet schrieb:Wir können ja nur von dem ausgehen, das wir haben, klar kann man behaupten, es ist nur eine philosophische Position, physikalischer Naturalismus, nicht bewiesen. Das Gegenteil auch nicht, und es ist schon ein guter wissenschaftlich und pragmatisch Ansatz, nennen wir es doch Arbeitsthese aller Neuro- und Lebenswissenschaften.

nocheinPoet schrieb:Wir können ja nur von dem ausgehen, das wir haben, klar kann man behaupten, es ist nur eine philosophische Position, physikalischer Naturalismus, nicht bewiesen. Das Gegenteil auch nicht, und es ist schon ein guter wissenschaftlich und pragmatisch Ansatz, nennen wir es doch Arbeitsthese aller Neuro- und Lebenswissenschaften.

Die Gehirnprozesse sind physikalisch kausal, teils vorhersagbar, teils stochastisch, und Anästhetika, Psychopharmaka, Läsionen, Neuroprothesen, das alles wirkt gesetzmäßig, hier haben wir klare Kausalität, keine robuste Evidenz für nicht physische Zusatzkräfte.

Es ist eben so, da ist eine Eizelle und ein Spermium, kann ein Embryo ergeben, die Wissenschaft geht hier aber noch nicht von Bewusstsein aus, wir können ja aber auch erstmal nur von einem Haufen Zellen sprechen. Das ist ganz klar organische Chemie, Determinismus und etwas Zufall aus der QT. Und es entwickelt sich weiter und weiter, und irgendwann ist da ein Hirn, was soll da noch zukommen?

Du sagst ja selber, Geist interessiert Dich nicht, ich will da auch keine "Seele" postulieren, im Gegenteil. Nicht jeder muss ja mit meiner Aussage, wir haben hier nur Determinismus + Zufall, zufrieden sein. Wer das bestreit, müsste dann aber was wie Determinismus + Zufall + X haben, was soll hier X sein?

Und keiner kann belegen, dass es X hier nicht gibt. Wir können zeigen, ja da ist Determinismus, Naturgesetze und ja Zufall, auch Naturgesetze, beide ist ganz sicher da.

Ich behaupte, und bin damit nicht alleine, sondern schließe mich hier mal Sabine und anderen Wissenschaftlern an, dass wir mehr nicht haben, dahingebend war ja meine Frage, darum ging es ja, ich schrieb ja "Spirituelles", X wird nie so zu belegen sein, weil das ganz klar außerhalb unserer Naturgesetze liegt. Ein ominöse Kraft, die im Hirn was bewegt, nicht deterministisch ist, also nicht der Hirnchemie unterliegt, nichts mit Quanten, ja was dann? Dann hast Du den "Geist", den Du ja selber nicht haben willst.

Ist doch schon etwas, kannst ja mal darauf eingehen, so im Rahmen einer Diskussion.

Negev schrieb:Zumal Sie eingangs schon sagt: "Ein Philosoph hat gerade argumentiert, ja. " Was will mir nun dieser Philosoph über den aktuellen Stand von Neurologie und Informatik sagen? Und wie unterscheidet sich dieser Philosoph von dem anderen Philosophen, den ich zitiert hab, dem die einfach so Grundlagenwissen abspirchst:

Negev schrieb:Zumal Sie eingangs schon sagt: "Ein Philosoph hat gerade argumentiert, ja. " Was will mir nun dieser Philosoph über den aktuellen Stand von Neurologie und Informatik sagen? Und wie unterscheidet sich dieser Philosoph von dem anderen Philosophen, den ich zitiert hab, dem die einfach so Grundlagenwissen abspirchst: nocheinPoet schrieb am 19.08.2025:Es ist eine Meinung, von einem Philosophen, der schau mal wer Johannes Hartl und was er weiter schreibt. Und ja, er sollte die Grundlagen noch mal pauken, wobei mir eine seiner Aussagen gefällt, hab ich auch so schon öfter geschrieben, Descartes fängt zu spät an, er gibt die Existenz eines "Ichs" einfach voraus. Aber das geht viel tiefer in die Philosophie.

nocheinPoet schrieb am 19.08.2025:Es ist eine Meinung, von einem Philosophen, der schau mal wer Johannes Hartl und was er weiter schreibt. Und ja, er sollte die Grundlagen noch mal pauken, wobei mir eine seiner Aussagen gefällt, hab ich auch so schon öfter geschrieben, Descartes fängt zu spät an, er gibt die Existenz eines "Ichs" einfach voraus. Aber das geht viel tiefer in die Philosophie.

Mit welchem Recht tust du das?

Du hast ja explizit danach gefragt gehabt, ich habe das auch erklärt, seine Aussage war ja:

Wiederkehrende Frage bei solchen Gesprächen: wann wird es so weit sein, dass künstliche Intelligenz Bewusstsein entwickelt? Eine komplexe Frage, auf die es philosophisch jedoch eine klare Antwort gibt: niemals.

Quelle:

https://www.herder.de/communio/kolumnen/hartl-aber-herzlich/was-der-ki-fehlt-ist-das-was-uns-menschlich-macht-kuenstliches-bewusstsein/Er ist auch Theologe und ein wenig umstritten, aber das ist mal egal, er macht hier eine Tatsachenbehauptung, wir wissen hier inzwischen, so eine kann man nicht machen, egal ob Philosoph oder nicht. Wenn man die Grundlagen kennt, auch eben die der Philosophie, dann weiß man das, wenn man es weiß, sollte man so eine Behauptung nicht aufstellen. Entweder kennt er die Grundlagen nicht, oder behauptet etwas, von dem er weiß, man kann es so gar nicht wissen. Beides nicht so wirklich toll. Und darum eben meine Antwort. Da er auch Theologe ist, sollte er sich auch damit auskennen, dass man nicht die Unwahrheit sagt.

Hier hätte er ja auch einfach sagen können, seiner Meinung nach, niemals. Macht er aber nicht, er behauptet, es gäbe da philosophisch eine klare Antwort, die "niemals" ist.

Das ist eindeutig falsch, so eine Antwort gibt es nicht, auch nicht philosophisch, damit richtet er sich dann noch an Menschen, die wohl keine Philosophen sind und ihm das dann auch noch glauben. Und die nehmen das dann, zitieren es in Foren und erklären, sehet her, da steht es, KI kann niemals ein Bewusstsein haben, weil

Johannes Hartl hat das ja behauptet.

Negev schrieb:Deine Frage Impliziert, dass man nur mit genügend Skalierung so etwas wie eine Innenwahrnehmung bei LLMs erzeugen kann.

Negev schrieb:Das ist der Heilige Gral der KI-Forschung. Aber wann bekommen wir diese selbstoptimierende KI?

nocheinPoet schrieb:Ist doch recht klar, es geht nicht darum es gleichzusetzen, es geht um einen Vergleich um dann konkret einen eindeutigen Unterschied herauszuarbeiten.